机器学习—基本概念和表示

1. 概率

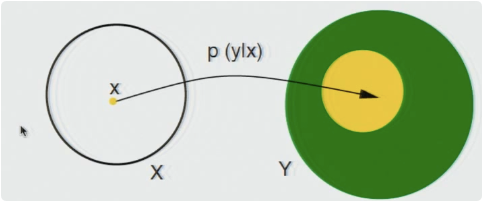

为什么是概率呢? 这是因为现实数据是真实数据的一个采样,相同的输入x,可以获得不同的y,通常用概率表示为![]() ,这是因为:

,这是因为:

- 隐含过程是确定性的, 但是y的测量中存在噪声;

- 隐含过程是非确定性的。

- 隐含过程是确定性的,但是可用信息不完整。

函数的映射关系如下: X,Y为随机变量。

2. 采样

即使在无噪声的情况下,我们必须处理采样:

- 输入点错误位置

- 给定网格离散化错误

- 是否存在某些输入实例

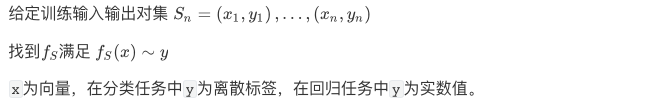

3. 学习问题

学习问题基本数学模型如下:

对于以上模型,为了使问题具有研究意义,我们假定输入和输出是相关的。

统计与监督学习

每一批输入和输出为固定,但分布未知,概率分布为:

训练集![]() 为独立同分布样本。

为独立同分布样本。

4. 泛化和预测

泛化:给定预测数据,根据学习算法预测不在训练集的数据,是机器学习特别强调的关键需求,泛化是预测一种测量标准,这与Bayesian或传统统计(特别是探索性统计)根本不同。机器学习最主要的任务在于减少过拟合。

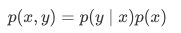

5. 损失函数和误差

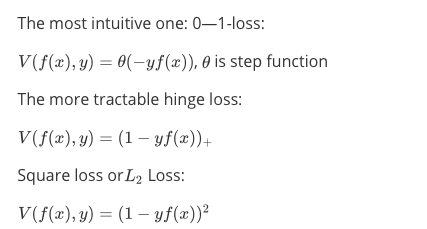

损失函数: 用来衡量预测值和真实值之间的差异,通常损失函数有:

回归损失函数:

二元分类损失函数:

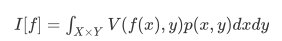

期望误差

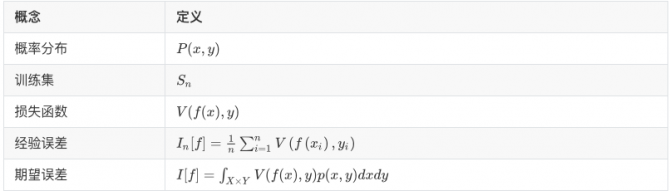

基本概念和符号定义如下表所示:

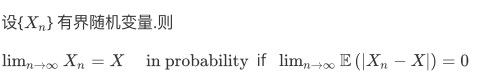

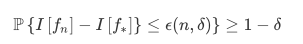

概率收敛性准则

期望收敛准则

如何度量错误的收敛程度,可以通过错误率(error rate)

或采用样本复杂度来衡量

经验风险:所有样本点预测值和真实值之间的平均差异。

泛化误差,衡量学习算法优劣性的标准,学习算法![]() ,在整个变量空间上的误差(期望误差)与样本点上误差(经验误差)随着n的收敛程度。

,在整个变量空间上的误差(期望误差)与样本点上误差(经验误差)随着n的收敛程度。

因此在理论和实践中的一些问题:

1. 如何确定实际算法类别,即使用哪种kernel?

2. 经验误差最小化一定能达到期望误差最小吗?

3. 在哪些条件下,经验误差可以很好地近似预期误差?

6. 无免费午餐理论

给定任意多个点(和一个置信度),我们是否总能达到预定的误差?

这个不可能的,可解释为:当且仅当问题满足先验条件时,才能从有限样本完成。

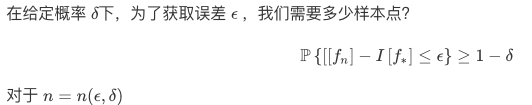

7. 统计学习模型

在许多学习算法中(并不是全部),我们需要选择合适的假设空间,假设空间就是允许算法进行查找的函数空间。对于许多算法(比如最优化算法),算法允许搜索的空间。选择假设空间作为可用数据量的函数通常非常重要。

此外对于泛化的关键特性,“好的”学习算法也应该是稳定(stable):应该连续于训练集S。 特别是,随着n趋于无穷大,更改其中一个训练点对解决方案的影响将越来越小。 稳定性对于学习问题,实际上对任何数学问题都是一个很好的要求。

Empirical Risk Minimization(ERM)期望误差最小化,即训练集上误差最小原则。

8. 算法稳定性

一个问题是适当性(well-posted)问题,其解存在且有且唯一。在何种条件下,ERM算法随着样例的增加收敛至真实解?ERM泛化条件是什么?

从 Tikhonov可知,一般非适定问题如ERM,可以保证至适定的、稳定的:

通过选择合适的 , 例如

, 例如 的简洁性保证稳定性。ERM一致性经典条件(Vapnik),对于适当约束。似乎相同可以使得数据稳定的约束,可以提供泛化解...

的简洁性保证稳定性。ERM一致性经典条件(Vapnik),对于适当约束。似乎相同可以使得数据稳定的约束,可以提供泛化解...